Es war vor der Zeit der PISA-Tests und der grossen Lehrplandiskussionen. Es war die Zeit, als die ersten Testverfahren auftauchten und sich in den Unterricht der Oberstufe drängten. Angefangen hatte es mit einem Eignungstest der Firma Multicheck AG, ein Schweizer Personaldienstleistungsunternehmen, das 1996 gegründet wurde. Es entwickelte den berühmten und wohl auch etwas berüchtigten Multicheck. Mit der Zeit verlangten viele Betriebe von ihren Bewerberinnen, den Unterlagen die Resultate dieses Tests beizulegen.

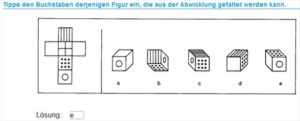

Die Aufgabenstellungen richteten sich nach dem Stoff, der am Ende der 8. Klasse behandelt sein sollte. Er setzte aber auch je nach Branche gewisse Schwerpunkte. So hatten KV-AspirantInnen einen anderen Test zu absolvieren als die angehenden Informatiker oder die Mechanikinteressierten. Die Prüfungen wurden immer ausgeklügelter und waren auch ziemlich teuer. 110 Fr. kostete das Testverfahren, das meistens an einem Samstagmorgen in einer Stadt in der Schweiz stattfand und ca. 4 Stunden dauerte. Rund 10 Tage danach hatten die getesteten SchülerInnen eine sehr detaillierte, nach Algorithmen berechnete Rückmeldung in ihrem Briefkasten liegen.

4 Stunden Prüfung, 110 Franken, Stoff der 8. Klasse

Als Lehrer der Sekundarstufe 1 – vorwiegend in Brennpunktschulen – interessierten mich natürlich die Art der Tests und auch die Bedingungen, unter denen diese Prüfungen stattfanden. Nach einem Gesuch erlaubte mir die Multicheck-AG, einmal an einem Samstagmorgen den ganzen Test mitzumachen. Es war eine sehr lehrreiche Erfahrung. Als 50-jähriger mit rund vierzig 15-jährigen Kids vier Stunden lang konzentriert zuerst einen Bleistifttest und danach die Aufgaben am Compi zu lösen, war anstrengend. Und der Stress der Jugendlichen links und rechts neben mir war greifbar, ging es doch um möglichst gute Resultate, welche über die Chancen zur Wunschlehrstelle entscheiden konnten. Es war also ein Test, der über Zugänge entschied.

Natürlich gab es schon vorher betriebsinterne Tests, welche in einer Zeit der knappen Lehrstellenangebote die (zu) vielen Bewerberinnen und Bewerber selektionieren wollten. Vor allem die Autobranche macht dies noch heute.

Zu Grunde lag diesen Tests ein wachsendes Misstrauen gegenüber den Zeugnissen der Schulabgänger. Viele Betriebe bemängelten, dass die Noten nicht mit dem Kenntnisstand ihrer frischen Lehrlinge übereinstimmten.

Und noch etwas fand ich im Jahr 2006 hochinteressant. Während sich bei uns in den Lehrmitteln allmählich offene Aufgabenstellungen, textlastige Mathematikaufgaben und Kompetenzorientierung breit machten, verlangte der Multicheck solide Mathematikkenntnisse nach altbewährtem Muster. 80% der Mathematikaufgaben waren beispielsweise proportionale Zuordnungen.

Diese Hinwendung zu externen Testverfahren als Ergänzung zu den «oft zweifelhaften Zeugnissen» empfanden nicht nur die Lehrkräfte als Kränkung. Auch diverse Bildungsdirektionen gaben mit der Zeit eigene Tests in Auftrag. Erziehungsdirektor Pulver im Kanton Bern begründete die staatlichen Testverfahren unter anderem ausdrücklich mit dem Argument, die privaten Anbieter dadurch aus dem Markt zu drängen. So entstanden die staatlich finanzierten Stellwerk- und Cockpit-Tests. Der Bildungsforscher Urs Moser witterte hier seine Chance. Er gründete 2005 das Institut für Bildungsevaluation als Aktiengesellschaft. Der Stellwerk-Test ist zwar ein Produkt des Lehrmittelverlags St. Gallen und wurde von einer Aufsichtskommission unter der Leitung des Erziehungsrates begleitet. Entwickelt und ausgearbeitet wurde er aber von Urs Mosers Institut.

Der ehemalige Fraktionschef der SP im bernischen Grossen Rat Roland Näf, selber Schulleiter, schwärmte an einem Podiumsgespräch mit mir von den Vorzügen dieser Tests. Diese würden es uns erlauben, die Schwachstellen in unserem Bildungssystem genau zu lokalisieren. Anschliessend könne man dann in einem staatlichen Monitoring den Handlungsbedarf verifizieren und entsprechende Reformen entwickeln. Diese würden dann dazu dienen, diese Schwachstellen zu beheben. Das Wort «Monitoring» machte die Runde. Ein Teil der SP-Bildungsspezialisten mutierten plötzlich zu begeisterten Befürwortern dieser Tests, was im immer noch existierenden Bildungsprogramm der SP-Schweiz seinen Niederschlag fand. Dort steht der Satz: «Die SP-Schweiz fordert schweizweit verbindlich definierte Bildungsstandards. Mittels standardisierter Tests sollen transparente und messbare Leistungsziele und darauf aufbauend Zertifikate vergeben werden»! (SP-Bildungsoffensive 2007). Das muss man sich mal auf der Zunge zergehen lassen. Die SP forderte damals nichts weniger als standardisierte Tests, welche sogar über Zugänge zu Bildungswegen entscheiden können (oder was um Gottes Willen bedeuten Zertifikate denn sonst?). Damit half sie auch tüchtig mit, alle Dämme zu brechen.

«Die SP-Schweiz fordert schweizweit verbindlich definierte Bildungsstandards. Mittels standardisierter Tests sollen transparente und messbare Leistungsziele und darauf aufbauend Zertifikate vergeben werden.»

(SP-Bildungsoffensive 2007)

Wir versuchten es in unserer Schule

Doch kommen wir zurück zum Versprechen des Monitorings. Ich bin durchaus nicht ein Mensch, der sich solch lockenden Aussichten verschliessen mochte. Und so setzte ich durch, dass wir an unserer Schule versuchshalber einen solchen Test durchführten. Wir entschieden uns für einen Mathematik-Test. Ich war damals Klassenlehrer einer 9. Klasse. 16 SchülerInnen, 8 albanischer Herkunft, eine Serbin, drei Türkinnen, zwei Portugiesen und zwei Schweizer mit Muttersprache Deutsch.

Der Stellwerktest war interessant. Er bot ansprechende Aufgaben am Compi und war klar strukturiert. Vor allem «spuckte» er in Rekordzeit die Korrekturen samt Bewertung und schweizweiter Vergleiche «aus».

Die Ergebnisse meiner Klasse liessen sich folgendermassen zusammenfassen. Meine Klasse lag unter dem schweizerischen Durchschnitt. Ein anderer Befund hätte mich auch sehr überrascht. Eine Schülerin rangierte bei 2,5%, will heissen nur 2,4% waren noch schlechter als sie selbst. Das verwunderte nicht. Dieses Mädchen hatte grosse Abstraktionsprobleme und ebenso schwerwiegende Mängel im logischen Denken. Ein Schüler bewegte sich bei 75%, gehörte also als Realschüler zu den sehr guten Mathematikern meiner Klasse. Auch das war natürlich keine Überraschung. Der Junge entwickelte sich prächtig und hätte – wenn er «den Knopf etwas früher aufgemacht hätte» – sicher in das Sekundarschulniveau wechseln können.

Und jetzt?

«Und jetzt?», fragte ich in die Runde unserer Mathematiklehrkräfte?

«Jetzt kommt ein Monitoring-Care-Team in deine Klasse und widmet sich dem Sachverhalt», spottete einer meiner Kollegen.

«Von denen habe ich schon genug!», antwortete ich trocken. Der Fall war klar. Der Test lieferte uns Daten, die wir erwartet hatten. Er bestätigte in fast allen Klassen unsere Beobachtungen und gab uns keine pädagogischen Impulse. Und deshalb hatte er auch keine unmittelbaren Folgen. Wo also sollte das hoch gepriesene Monitoring einsetzen?

Wenn Monitoring Makulatur wird

Seit Jahren stellen die PISA-Tests fest, dass ein Fünftel unserer Schülerinnen und Schüler nicht richtig lesen und schreiben kann. Wie sah hier das Monitoring aus? Frühfranzösisch, Mehrsprachendidaktik und selbstorganisiertes Lernen.

Vier Evaluationen ergaben, dass unsere Schülerinnen und Schüler mit den Lehrmitteln der Passepartout-Reihe die angestrebten Lernziele bei weitem nicht erreichten. Wie sah hier das Monitoring aus? Beschwichtigungen, Versprechungen, Überarbeitungsankündigungen!

Die ÜGK (Überprüfung der Grundkompetenzen, März 2019) sah die Stadt

Basel – wieder einmal – abgeschlagen auf dem letzten Platz der innerkantonalen Ranglisten. Wie sah hier das Monitoring aus? Erziehungsdirektor Cramer meinte resigniert: «Wir sind halt ein Stadtkanton». Und der frischgebackene Nationalrat der SP, Mustafa Atici, forderte in der BAZ: «Mehr Geld für die Bildung!» Notabene in einem Halbkanton, der mit 20’000 Fr. pro Schüler Rekordinvestitionen tätigt (im Gegensatz zum Spitzenreiter Fribourg mit knapp 10.000 Fr.).

Das von der Linken so hochgelobte Monitoring ist ein Phantom. Die Allianz von Wissenschaft, Verwaltung und Politik hat ihre eigene Agenda. Und die heisst in den meisten Fällen: Wie komme ich in eine Arbeitsgruppe, wie werde ich wahrgenommen, wo werde ich an einen Kongress eingeladen und vor allem: Wie ergattere ich mir die nächsten Aufträge?

Man hyperventiliert über Länderranglisten, man überbietet sich mit gewagtesten Ursachenanalysen ganz nach dem Motto: Es muss was geschehen, aber es darf nichts passieren.

Ich bin nicht grundsätzlich gegen externe Testverfahren. Richtig durchgeführt und vor allem richtig interpretiert, können sie uns brauchbare Daten liefern, die uns faktenbasierte Handlungsmöglichkeiten bieten. Aber diese werden ja überhaupt nicht relevant diskutiert. Man hyperventiliert über Länderranglisten, man überbietet sich mit gewagtesten Ursachenanalysen ganz nach dem Motto: Es muss was geschehen, aber es darf nichts passieren.

Das Monitoring-Versprechen ist ein Alibi

Und so werden auch keine Verbesserungen in den Schülerleistungen erzielt, im Gegenteil, sie sinken, und zwar genau in den Bereichen, die den Kern unserer Schule ausmachen. Das Monitoring-Versprechen ist ein Alibi für wirkungslose Geldflüsse, brachte unter anderem eine wahre Testlawine, Kompetenzorientierung und Steuerungswahn und ist mitnichten ein Instrument, mit dem Fehlentwicklungen rückgängig gemacht werden. Passepartout und Frühfranzösisch lassen grüssen.