Über Schule, Unterricht und Lernmaschinen

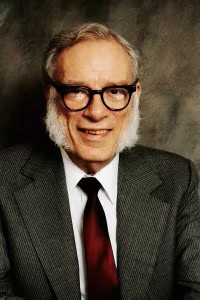

Der russisch-amerikanische Wissenschaftler und Science-Fiction-Autor Isaac Asimov schrieb 1954 eine Geschichte über die “Schule der Zukunft”. Im Jahr 2157 (Originaltitel: “The fun they had”) gebe es gar keine Schulen mehr, weil neben jedem Kinderzimmer ein kleiner Schulraum eingerichtet sei, in dem die Kinder und Jugendlichen von einem mechanischen Lehrer (einer Maschine mit Bildschirm und einem Schlitz zum Einwerfen der Hausaufgaben) unterrichtet würden. Diese Lehrmaschine sei perfekt auf die Fähigkeiten des jeweiligen Kindes eingestellt und könne es daher optimal beschulen. Besser als jeder Mensch. Nur: Maschinen können kaputtgehen. Die elfjährige Margie wird von ihrem mechanischen Lehrer wieder und wieder in Geographie abgefragt, gibt die richtige Antwort, wird aber jedes Mal schlechter benotet. Daher ruft die Mutter den Schulinspektor, um den mechanischen Lehrer zu reparieren.

“Margie hatte gehofft, dass er ihn nicht wieder zusammenbringen würde, aber er hatte Bescheid gewusst, und nach einer Stunde oder so hatte das Ding wieder dagestanden, groß und schwarz und hässlich, mit einer großen Mattscheibe darauf, wo alle Lektionen gezeigt wurden, und mit einem Lautsprecher daneben, der die Fragen stellte. Aber das war nicht das Schlimmste. Der Teil, den Margie am meisten hasste, war ein Schlitz, in den sie alle Hausarbeiten und die Antworten auf seine Fragen stecken musste. Alles das musste sie in einem Lochcode schreiben, den sie mit sechs Jahren gelernt hatte, und der mechanische Lehrer rechnete die Noten im Nu aus.” (Asimov 2016)

In wenigen Sätzen beschreibt Isaac Asimov, was heute zum Teil bereits Praxis ist oder, geht es nach den Anbietern solcher Systeme, Alltag werden soll: Kinder sitzen an Bildschirmen und werden von Apparaten beschult. Unterrichten und Prüfen wird an Maschinen und Software delegiert, digitalisiert und entpersonalisiert. Lernen selbst wird auf automatisiertes, abprüfbares reduziert, weil weder eine Lernmaschine noch eine Software “versteht”, was sie berechnet, egal, wie komplex sie ist. Die Microsoft- Deutschland-Chefin Sabine Bendiek präzisiert: “Eine KI kann viele Dinge ganz toll, aber letztlich rechnet sie auf Basis von großen Datenmengen.” (Armbruster 2019).

Unterrichten als interpersonaler Prozess ist immer an Menschen und den direkten Dialog gebunden.

Daran muss erinnert werden, weil im Kontext der aktuell diskutierten KI-Systeme auf Basis großer Sprachmodelle (Large Language Models, LLM) wie ChatGPT, Bard u. a. und der von diesen Systemen generierten Texte die Grenze zwischen Mensch und Maschine in beide Richtungen aufgelöst, Maschinen zu Lebewesen überhöht werden. Eine Maschine, mit der man sich “fast wie mit einem Menschen” unterhalten kann, ist doch (fast) ein Mensch? Nein. Es ist der Mensch als kommunikatives und soziales Wesen, der Apparaten menschliche Attribute zuweist, weil er ein Gegenüber braucht.

Auf dieses Wechselspiel (und Irrtum) aus Anthropomorphismus (die Vermenschlichung und Zuschreibung menschlicher Eigenschaften an Maschinen) und Animismus (die Zuschreibung mentaler Eigenschaften an Maschinen) weist der Deutsche Ethikrat in seiner Stellungnahme “Mensch und Maschine – Herausforderungen durch Künstliche Intelligenz” von 2023 hin.

Historische Konstante

Die Vermenschlichung von Objekten und Maschinen ist dabei eine historische Konstante, bekommt ihre besondere Dynamik aber dadurch, dass diese IT- und KI-Systeme bereits flächendeckend im Web, in Suchmaschinen und Apps im Einsatz sind, ohne dass wir es bemerken oder Einfluss darauf nehmen können. Siri, Cortana und Sprach-Bots wie beim Routenplaner sind alltäglich.

Dabei gilt: Unterrichten als interpersonaler Prozess ist immer an Menschen und den direkten Dialog gebunden. Das pädagogische Dreieck beschreibt die zwei beteiligten Parteien, die notwendig präsent und einander zugewandt sein müssen, um von pädagogischer Arbeit und Unterricht zu sprechen: Lehrende und Lernende. Dazu kommt als Drittes die Sache als Unterrichtsgegenstand der Vermittlung, das Thema oder das Fach des Unterrichtens. Bei Bedarf und je nach Altersgruppe, Thema und Möglichkeit ergänzen (analoge wie digitale) Medien das Lehren und Lernen.

Das gemeinsame Lehren und Lernen findet in einem sozialen Raum statt und ist ein dialogischer, diskursiver Prozess. Der klassische Begriff dafür lautet “Unterrichtsgespräch” und wurde bereits in der Akademie des Sokrates erfolgreich praktiziert.

Lernen an Lernstationen hingegen ist weder selbstbestimmt noch individualisiert. Das Lernziel ist ebenso vordefiniert wie die Lernpfade. Individualisierung bedeutet hier nur Varianz und Anzahl der möglichen Zwischenschritte.

Das ist zwar eine mögliche Form des Lernens, vor allem für fortgeschrittene Lerner, aber kein Unterricht. Das selbstständige Lernen mit Medien setzt zudem Vorwissen, Reflexionsvermögen und Urteilskraft sowie Selbstdisziplin voraus. Mediengestützte Selbstlernphasen sind ein Ziel von Erziehung und Unterricht, um Jugendliche und vor allem Erwachsene (im Studium!) an das eigenständige, auch inhaltlich selbstbestimmte Lesen, Lernen und Forschen heranzuführen (bei wissenschaftlichen Karrieren). Es ist keine Fertigkeit von Kindern und nur weniger Jugendlicher, und nur wenige Erwachsene bewahren sich diese intrinsisch motivierte Form der Neugier und Bereitschaft zur Anstrengung.

Lernen an Lernstationen hingegen ist weder selbstbestimmt noch individualisiert. Das Lernziel ist ebenso vordefiniert wie die Lernpfade. Individualisierung bedeutet hier nur Varianz und Anzahl der möglichen Zwischenschritte. Es ist algorithmisch gesteuertes “Teaching to the Test”, mit kleinteilig integrierten Prüfschleifen und Berechnung der nächsten Aufgaben durch Lernkontrollsoftware. Das Ziel ist vorgegeben und soll möglichst effizient erreicht werden. Technische Systeme arbeiten heute zwar, anders als bei Asimov, mit Avataren: digital generierte Figuren als Pseudo-Charaktere mit ebenso computergenerierter Stimme. Aber das Prinzip sozialer Isolation am Display (heute Touchscreen), die Reduktion von Lernprozessen auf das Abarbeiten vorgegebener Aufgaben mit dem Ziel der Abprüfbarkeit und technisch generierter statt zwischenmenschlicher Interaktion hat Asimov vorweggenommen.

Eine Maschine “versteht” ja nicht, was an Texten oder Grafiken angezeigt, per Sprachsoftware artikuliert oder als nächste Aufgabe gestellt wird. Maschinen funktionieren nach Steuerungsanweisungen. Sie funktionieren korrekt oder sind falsch konfiguriert bzw. defekt. Maschinen (Computer sind Rechenmaschinen) haben kein Bewusstsein, keinen Willen und keine Absicht. Ein Computersystem kann weder reflektieren noch argumentieren. Alles muss als konkrete Handlungsanweisung hinterlegt sein. Es sind kybernetische Steuerungssysteme, die nur “Richtig” (0) oder “Falsch” (1) kennen. Dazu werden komplexe Aufgaben in immer kleinere Teilaufgaben zerlegt, die mathematisch berechnet und nach dem Binärsystem (0/1, Ja/Nein) beantwortet werden (können).

Die Automatisierung von Lernprozessen

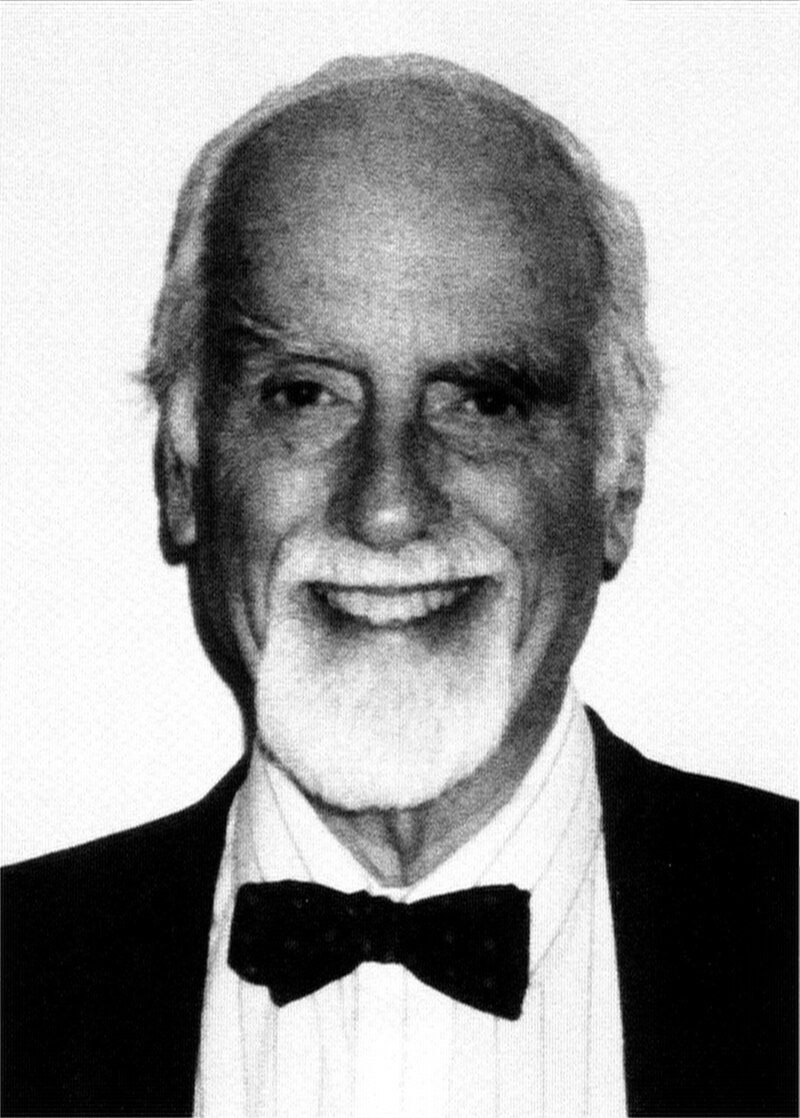

Die Idee, Unterricht und Lehre ließe sich automatisieren und automatisiert prüfen, ist älter als Computer oder Internet. In seiner kurzen Geschichte der Unterrichtsmaschinen schreibt Claus Pias über “Lerngutprogrammierung, Lehrstoffdarbietungsgeräte und Robbimaten” (Pias 2013). Er referiert über die Thesen des Psychologen Pressey, der bereits 1926 beklagt hatte, Erziehung hätte den geringsten Wirkungsgrad aller denkbaren Unternehmungen, weshalb der Lehrbetrieb arbeitswissenschaftlich (nicht pädagogisch!) optimiert werden müsse.

“Im Klartext: Wie bekommt man mit möglichst wenig Ressourcen möglichst viel Stoff möglichst schnell in die Köpfe?” Vorläufer und Impulsgeber waren Psychologen wie William Stern, der bereits im Jahr 1900 die “Psychologisierung des gesamten menschlichen Lebens” prognostizierte. Stern und Kollegen wie Hugo Münsterberg postulierten 1912 als psychotechnische Maxime: “Alles muss messbar sein.” Psycho-Technik wurde zur Leitdisziplin des “Psycho-Ingenieurs” und ist heute Grundlage empirischer Bildungsforschung. Empirie basiert auf Beobachtung und (personalisierten) Daten. Um der oder dem Lernenden die “passgenauen Angebote” machen zu können, müssen die Probanden möglichst kleinteilig und genau vermessen werden. Dazu dienen heute digitale Endgeräte und der personalisierte Login. “Das System” muss wissen, wer vor dem Bildschirm sitzt:

Viele dieser Lernsysteme sind interaktiv, stellen sich also ganz individuell auf den einzelnen Schüler ein und “erinnern” seine Schwächen und Stärken genau. (…) Das ist kein Hexenwerk, denn sobald man sich bei einem solchen Lernsystem registriert und eingeloggt hat, kann dieses alle Interaktionen der eingeloggten Person genau zuordnen. Sie kann Vergleichsanalysen mit den Verhaltensdaten aller anderen jemals eingeloggten Lerner durchführen und darauf aufbauend die weiteren Interaktionen dem anvisierten Lernziel entsprechend steuern. Viel genauer als das dem Lehrer im Unterricht mit der Klasse möglich ist, können dabei die Schwächen der einzelnen Schüler überwunden und zielgenau ihre Stärken individuell gefördert werden. (Meinel 2020)

Der Mensch wird zum Datensatz

Aus personalisierten Nutzerdaten lassen sich die fünf Dimensionen der Persönlichkeitspsychologie des Fünf- Faktoren-Modells (engl. OCEAN für Openness to expe- rience, Conscientiousness, Extraversion, Agreeableness, Neuroticism) berechnen. Diese Persönlichkeitsmerkmale (in Deutsch: Offenheit, Gewissenhaftigkeit, Extrovertiertheit, Verträglichkeit und emotionale Stabilität in der jeweiligen Ausprägung auf einer Skala von -5 bis+5) ergeben präzise Abbilder der Persönlichkeitsstruktur, der mentalen und psychischen Belastbarkeit und der Leistungsbereitschaft, des emotionalen wie des sozialen Verhaltens, der sexuellen Präferenzen u. v. m.

Das Ziel ist, mit Hilfe dieser Daten menschliches Verhalten möglichst effizient zu beeinflussen.

Der Mensch wird zum Datensatz und in seiner Psyche und Persönlichkeit transparent. Zusammen mit Bewegungs- und Kommunikationsprofilen aus anderen digitalen Kanälen (Social-Media-Apps, Browserverläufe, Metadaten über das Kommunikationsverhalten) entstehen präzise Persönlichkeits- und Verhaltensprofile.

Das Ziel ist, mit Hilfe dieser Daten menschliches Verhalten möglichst effizient zu beeinflussen. Die eher freundliche Variante heißt “Nudging” (Anstupsen), die weniger freundliche persuasive (verhaltensändernde) Technologien. Die Methoden dafür hat Edward Bernays 1928 beschrieben.

Für Psychologen sind selbst Emotionen und Einstellungen “Kompetenzen”, die sich trainieren und zur Selbstoptimierung (oder Fremdsteuerung) verändern lassen. Der Psychoingenieur David McClelland leitete daraus bereits 1973 das “pädagogische Versprechen einer umfassenden Formbarkeit des Menschen” ab (zit. n. Gelhard 2011; McClelland 1973). Das Aufzeichnen des menschlichen Verhaltens wird heute über digitale Endgeräte wie Smartphone, Smartwatch und Tablet mit eingebauten Kameras und Mikrofon realisiert. Nach dem Einloggen über eine persönliche Identifikationsnummer (ID) liefern diese Geräte personalisierte Lern- und Verhaltensdaten ebenso in Echtzeit wie alle Akte der Kommunikation sowie Bewegungs- und Geodaten. Das “System” weiß, wo wir sind, was wir tun, mit wem wir wie oft und wie lange kommunizieren. Die Metadaten sind viel aussagekräftiger als die (meist trivialen) Inhalte.

Nutzersteuerung durch digitale Zwillinge

Steuerbarkeit der Probanden ist das Ziel kybernetischer Systeme. Zu Beginn der 1950er Jahren stritten zwei Fraktionen um die Deutungshoheit. Kybernetiker in der Nachfolge von Norbert Wiener, dem Namensgeber der Kybernetik, arbeiten mit mathematischen Modellen. Behavioristen in der Tradition des Biologen B. F. Skinner (Vordenker des programmierten Lernens) nutzen (Verhaltens-)biologische Modelle.

Gemeinsam ist Kybernetik wie Behaviorismus die Überzeugung, dass der Mensch als (mathematisches resp. biologisches) Regelsystem definiert und mit Hilfe entsprechender Parameter gesteuert werden könne: als mathematisch-technisches System bzw. als “Input-Output-Schemata” (Blackbox) als biologistische Variante.

Eine Uhr weiß nicht einmal, was Zeit ist! Daher ist auch das ganze Gerede von der “Herrschaft der Maschinen” Science Fiction und Angstmacherei. Maschinen wollen weder Herrschaft noch Macht.

Dabei gilt: “Künstliche Intelligenz” ist allenfalls die “Simulation von Intelligenz” (Hansch 2023), da Datenverarbeitungsmaschinen auf der mathematischen Grundlage von Mustererkennung, Wahrscheinlichkeitsrechnung und Statistik rechnen und bei generativen KI-Systemen zum Beispiel Texte, Grafiken, Videos oder Computercodes generieren. Diese mögen formal so aussehen, als hätten Menschen sie produziert. Das gelingt, weil alle menschlichen Kommunikations- und Zeichensysteme regelbasiert, d. h. logisch und systematisch aufgebaut sind (Stichwort Semiotik). Regelsysteme kann man mathematisch nachbilden und ebenso regelbasiert ablaufen lassen – wie ein Uhrwerk. Nur weiß eine Uhr nicht, wie spät es ist, egal, wie exakt sie läuft. Eine Uhr weiß nicht einmal, was Zeit ist! Daher ist auch das ganze Gerede von der “Herrschaft der Maschinen” Science Fiction und Angstmacherei. Maschinen wollen weder Herrschaft noch Macht. Sie haben weder ein Bewusstsein noch irgendwelche Absichten oder Ziele. Computer, Software und Apps werden für konkrete Zwecke konstruiert und erfüllen ihre Funktion – oder müssen repariert, korrigiert, umprogrammiert werden.

Während die Steuerung von Maschinen und Prozessen durch IT und KI die Aufgabe von Ingenieuren und Informatikern ist, verstößt die Steuerung von Menschen durch IT und KI gegen deren Persönlichkeits- und Selbstbestimmungsrecht. Die US-amerikanische Wirtschaftswissenschaftlerin Shoshana Zuboff hatte schon 1988 das Prinzip der IT formuliert. Digitalsysteme sind per se Kontrollsysteme: Automatisieren. Digitalisieren. Kontrollieren. (Zuboff 1988). Das kritisiert sie aktuell mit dem Begriff “Überwachungskapitalismus” (Zuboff 2018). Das nannte Frank Schirrmacher bereits 2015 technologischen Totalitarismus.

Das macht Digital- als Kontrollinstrumente für den Einsatz in Sozialsystemen – und insbesondere Bildungseinrichtungen – so schwierig bzw. ungeeignet. Denn aus diesen Daten lassen sich Persönlichkeitsprofile (digitale Zwillinge) generieren, mit denen man Verhalten prognostizieren und testen kann. Bei KI-Systemen in Schulen kommt noch etwas Elementares dazu: “KI ruiniert das Motivationsgefüge des herkömmlichen Unterrichts”, so der Pädagoge Gottfried Böhme und führt aus: “Künstliche Intelligenz bricht der Schule, wie sie heute existiert, das Rückgrat. Es hat in der Geschichte der Bildungseinrichtungen noch nie eine Erfindung gegeben, die so infam die gesamte Motivationsstruktur des Lernsystems infrage gestellt hat wie diese Atombomben-KI – um mich hierdeutlich zu outen. Wir ziehen gerade eine Generation von Jugendlichen heran, die eine Zeitlang ihren Lehrern noch vorgaukeln kann, dass das, was ihnen ChatGPT oder ein anderes Programm geschenkt hat, ihre Leistung sei, und bald nicht mehr wissen, warum sich Lernen überhaupt noch lohnen soll.” (Böhme 2023)

Wirtschaftsinteressen vs. Pädagogik

In der öffentlichen Diskussion werden solche Bedenken nicht thematisiert, da bestimmen Fortschrittsglauben und Technikdeterminismus den Diskurs. KI-Systeme seien auf dem Markt, würden von Lehrkräften, Schüler/innen ohnehin eingesetzt und müssten daher in die Schule integriert werden. So überlässt man die Frage, mit welchen Medien unterrichtet wird, den Anbietern dieser Systeme (siehe UNESCO-Bericht 2023). Den fehlenden Nutzen und Mehrwert von IT und KI (Balslev 2020) kompensieren die Digitalanbieter durch die Behauptung, dass bereits die Frage nach dem Mehrwert und Nutzen von IT und KI in Schulen falsch gestellt sei.

So argumentiert z. B. das Forum Bildung Digitalisierung e.V., ein Zusammenschluss privater Stiftungen, die sich für eine “systemische digitale Transformation im Bildungsbereich” einsetzen. Die in diesem Forum durch ihre Stiftungen vertretenen Unternehmen kommen aus der IT- und Telekommunikationswirtschaft (Vodafone, Telekom) und/ oder sind selbst Akteure der Digitalisierung bzw. Bildungsindustrie. Ihr Credo: “In Projekten, Publikationen und Veranstaltungen identifizieren wir Gelingensbedingungen für den digitalen Wandel an Schulen und navigieren durch die notwendigen Veränderungsprozesse” (FBD 2022). Im Gefolge solcher Stiftungen finden sich selbstredend digitalaffine Lehrkräfte, Blogger und “Bildungsinfluencer”, die derartige Setzungen übernehmen und ebenfalls über Bildung nur noch “unter den Bedingungen der Digitalisierung” diskutieren (wollen).

“Wir ziehen gerade eine Generation von Jugendlichen heran, die eine Zeitlang ihren Lehrern noch vorgaukeln kann, dass das, was ihnen ChatGPT oder ein anderes Programm geschenkt hat, ihre Leistung sei, und bald nicht mehr wissen, warum sich Lernen überhaupt noch lohnen soll.”

Pädagoge Gottfried Böhme

“Probleme kann man niemals mit derselben Denkweise lösen, mit der sie entstanden sind” soll Albert Einstein formuliert haben. Wer die ernüchternden Ergebnisse des letzten PISA-Tests von 2022 oder des IQB-Bildungstrends 2021 zu den schulischen Leistungen der bundesdeutschen Primarschülerinnen und -schüler verfolgt hat, wird womöglich an Georg Pichts “Bildungskatastrophe” von 1964 erinnert oder an gleichnamige Reaktionen nach dem ersten PISA-Test von 2000. Die messbaren Lernleistungen haben seither, trotz stetig neuer Testreihen und des Aufbaus einer ganzen Testindustrie, nach einer kurzfristigen Steigerung (durch das Üben der Testaufgaben) konsequent abgenommen. Selbst die Mindeststandards elementarer Fähigkeiten wie Lesen, Schreiben, Zuhören und Rechnen werden von immer weniger Kindern erreicht.

Statt der sozialen Isolation am Display (samt daraus entstehender psychischer Probleme wie Vereinsamung und Entsozialisierung) muss der Dialog in und mit der Klassen- und Lerngemeinschaft wieder der Kern pädagogischer Praxis werden. Bildungseinrichtungen sind keine Zurichte-Anstalten für die Kompetenzvermessung, sondern müssen sich auf ihren Ursprung besinnen: ein Ort der Muße, der Wertevermittlung und Bildung zu sein, in der Menschen zu mündigen, selbstverantwortlichen Persönlichkeiten werden, die sich aus intrinsischer Motivation und Überzeugung in die Gesellschaft einbringen. Auf einem Schulleitungssymposium in der Schweiz wurden bereits 2017 als bildungspolitische Ziele Kriterien einer adäquaten Bildung für eine offene Zukunft formuliert: “eine stärkere Perspektivenorientierung auf Persönlichkeitsentwicklung, Mündigkeit, Förderung von Gemeinschaftssinn, Selbstverantwortung, verantwortungsvolle Partizipation an der Demokratie und achtungsvoller Umgang mit der fragilen Umwelt” (Simanowski 2021). Keines dieser Lernziele lässt sich per IT und KI vermitteln. Solche Werte als Grundlage für eigenes Handeln entstehen nur in Präsenz, durch Bindung und Vertrauen, Dialog und Diskurs.

Fazit

Der israelische Historiker Yuval Noah Harari wurde gefragt, warum er kein Smartphone besitze. Die Antwort des Wissenschaftlers, der sich dezidiert mit den Auswirkungen der Digitalisierung auf menschliches Verhalten befasst hat, lautet: Er sei nicht naiv und wisse, dass er in einer zunehmend smarten Umwelt auch ohne Smartphone verfolgt werden könne. Es gehe um mehr: “Der Hauptpunkt ist, Ablenkungen fernzuhalten. Ich weiß, wie schwierig es ist, den Geist zu kontrollieren, konzentriert zu bleiben. Und außerdem: Die Menschen auf der anderen Seite des Smartphones – die klügsten Menschen der Welt – haben in den vergangenen 20 Jahren gelernt, wie man das menschliche Gehirn durch das Smartphone hacken kann. Denen bin ich nicht gewachsen. Wenn ich gegen die antreten muss, werden sie gewinnen. Also gebe ich ihnen nicht meinen Bildschirm, gewähre ihnen keinen direkten Zugang zu meinem Gehirn.” (Matthes 2021)

Asimovs Lernmaschine kann heute Gehirne hacken

In den USA gilt seit 1998 der “Childrens Online Privacy Protection Act” (COPPA), der das Speichern und Auswerten von Daten Minderjähriger unter 13 Jahren unter Strafe stellt. Eine entsprechende Regelung fehlt in der EU. Der zweite Schritt wäre der konsequente und ausschließliche Einsatz von Free Open Source Software (FOSS) und das Kappen des Rückkanals für Nutzerdaten. Technisch ist das alles machbar. Die entscheidende Frage für Bildungseinrichtungen ist dabei: Gelingt es, Digital- und Netzwerktechnologien zur Emanzipation und Förderung der Autonomie der Menschen und deren Handlungsfreiheit einzusetzen (Lankau 2020) oder bleiben IT-Systeme Machtinstrumente der IT-Monopole zur (Verhaltens-)Steuerung von Menschen?

Literatur

Armbruster, A.: Nicht jeder muss ein Informatiker sein, Interview mit Microsoft-Deutschland-Chefin Sabine Bendiek, FAZ v. 01.04.2019; https://www.faz.net/aktuell/wirtschaft/ diginomics/microsoft-deutschland-chefin-sabine-bendiek-im- interview-16117321.html (3.5.2024).

Asimov, I.: Die Schule [1954]. In: Geliebter Roboter. München 32016, 154-158.

Balslev, J.: Evidence of a potential. The political arguments for digitizing education 1983-2015. Ph. D. Dissertation, Jesper Balslev, Department of Communication and Arts, Roskilde University. January 2020.

Böhme, G.: ChatGPT bricht der Schule das Rückgrat. In: FAZ vom 14.9.2023.

Brühl, J.: Ein Jahr Chat-GPT: Keine Hoffnung auf Luxuskommunismus. In: SZ vom 30.11.2023, 18.

Deutscher Ethikrat: Stellungnahme „Mensch und Maschine – Herausforderungen durch Künstliche Intelligenz“ des

Deutschen Ethikrats vom 20. März 2023, hier Kap. 3.4.2 Der Mensch als Maschine – die Maschine als Mensch? 2023, 107f. FBD: Forum Bildung Digitalisierung: 2022. https://www. forumbd.de/verein/; 20.11.2022.

Gelhard, A.: Kritik der Kompetenz. Zürich 2011.

Gruschka, A.: Verstehen lehren. Ein Plädoyer für guten Unterricht. Ditzingen 2011.

Haidt, J.: Generation Angst. Hamburg 2024.

Hansch, D.: Der ehrlichere Name wäre „Simulierte Intelligenz“. In: FAZ vom 1.3.23, N2.

Herkersdorf, M.: KI-basierte Avatare als empathische Lernbegleiter; eLearning-Journal. 2020. https://www.elearning-jour- nal.com/2020/05/14/empathische Lernbegleiter/ (6.3.22). IQB-Bildungsbericht. 2022. https://www.iqb.hu-berlin.de/bt/ BT2021/Bericht/

Lankau, R.: Alternative IT-Infrastruktur für Schule und Untericht. Wie man digitale Medientechnik zur Emanzipation und Förderung der Autonomie des Menschen einsetzt, statt sich von IT-Systemen und Algorithmen steuern zu lassen. Köln 2020.

Lankau, R. (Hrsg.): Die pädagogische Wende. Über die not- wendige (Rück-)Besinnung auf das Unterrichten. Heidelberg 2024.

Matthes, S.: Sie haben gelernt, unser Gehirn zu hacken, Interview mit dem Historiker Yuval Noah Harari. In: Handelsblatt vom 30. Dezember 2021 bis 2. Januar 2022, Nr. 253, 16-18. https://futur-iii.de/2022/01/sie-haben-gelernt-unser-gehirn-zu- hacken/ (12.6.2023).

McClelland, D. C.: Testing for competence rather than for „intelligence“. American Psychologist. 1973, 28(1), 1-14. https:// doi.org/10.1037/h0034092

Meinel, Ch.: Individualisierung: Bildungsdaten der Schüler schützen. 2020. https://blog.hpi-schul-cloud.de/individuelle-foerderung-mit-interaktiven-lernsystemen/ (16.9.20) (letzter Zugriff: 24. Mai 2024).

Pias, C.: Eine kurze Geschichte der Unterrichtsmaschinen, FAZ vom 10. Dezember 2013. www.faz.net/aktuell/feuilleton/forschung-und-lehre/automatisierung-der-lehre-eine- kurze-geschichte-der-unterrichtsmaschinen-12692010.html (30.6.2022).

Simanowski, R.: Digitale Revolution und Bildung. Weinheim 2021, 92.

UNESCO: Technology in Education – A tool on whose terms? 2023. https://www.unesco.org/gem-report/en/technology, dt. Übersetzung und Auszüge: https://die-pädagogische-wende. de/unesco-bericht-zu-it-in-schulen-fordert-mehr-bildungsgerechtigkeit/ (24. Mai 2024).

Weizenbaum, J.: Die Macht der Computer und die Ohnmacht der Vernunft. Frankfurt 1976.

Wiener, N.: Cybernetics or Control and Communication in the Animal and the Machine (dt. Kybernetik: Regelung und

Nachrichtenübertragung im Lebewesen und in der Maschine). Düsseldorf 1948 (1963).

Wiener, N.: Mensch und Menschmaschine. Kybernetik und Gesellschaft. Frankfurt 2022.

Zuboff, S.: In the Age of the Smart Machine. The Future of Work and Power. New York 1988. Basics Book.

Zuboff, S.: Zeitalter des Überwachungskapitalismus. Frankfurt 2018

Angesichts des letzten Fragesatzes von Herrn Lankau neige ich dazu, sehr skeptisch zu sein. Digitalisierung im Sinne des Ersetzens von Lehrern durch Lernsoftware oder Roboter ist ja nur die eine Seite. Die andere Seite ist das umfassende Sammeln und Zusammenführen von Daten aus den Schulen (oder auch Kitas) zum Zwecke der weiteren Verarbeitung durch übergeordnete Instanzen, also alle kleineren Einzelleistungen und -fehlleistungen von Schülern und alle Anmerkungen, die Lehrer über ihre Schüler pflichtgemäß in ihr digitales Gerät schreiben (etwa: “Grundschüler Hugo ist introvertiert und erkennt nicht die Vorzüge der Gruppenarbeit für die Entwicklung der Teamfähigkeitskompetenz”). Dieses “Monitoring” hätte einen ähnlichen Effekt wie eine permanent laufende Überwachungskamera im Unterricht. Und dieses wird — so seltsam das klingt — ganz ungeniert als wichtiger Beitrag zur Bildungsgerechtigkeit propagiert, hier zum Beispiel von der Bildungswissenschafts-Professorin Anne Sliwka in einer Publikation der “gemeinnützigen” Wübben-Stiftung (“Mehr Bildungsgerechtigkeit durch datengestützte Schul- und Schulsystementwicklung”):

https://www.wuebben-stiftung-bildung.org/wp-content/uploads/2024/02/WSB_impaktmagazin_Bildungsgerechtigkeit_durch_Daten_Februar2024.pdf

Wenn man die dortigen Formulierungen liest, kann man staunen. Da steht also:

“Die Herausforderung besteht darin, diese Daten nicht nur punktuell zu erfassen und zu analysieren, sondern sie kontinuierlich – auf und zwischen mehreren Ebenen des Schulsystems – für den Prozess der Schulsystemsteuerung zu nutzen. Eine adaptive Steuerung des Schulsystems erfordert, dass Bildungsmonitoring-Daten nicht nur zur Kenntnis genommen, sondern aktiv für die Entwicklung und Umsetzung konkreter strategischer Ziele verwendet werden. Dies beinhaltet eine regelmäßige Überprüfung und Anpassung der Bildungsstrategien auf den verschiedenen Ebenen – von der Einzelschule über den Schulbezirk bis hin zur Ebene der Bundesländer. Ein solcher Ansatz ermöglichtes, flexibel auf sich wandelnde Bedürfnisse, Herausforderungen und Entwicklungen zu reagieren und sicherzustellen, dass die gesetzten Bildungsziele erreicht werden.”

Klingt das nicht schon verdächtig nach “Big Brother is watching you”?

Es fehlt nicht einmal eine Reminiszenz an die 5-Jahrespläne in der DDR:

“Ein entscheidender Aspekt dabei ist die hohe Regelmäßigkeit

und Verbindlichkeit in den Arbeitsprozessen der Datennutzung.

Sie manifestiert sich dadurch, dass klar definierte, messbare

Ein- und Dreijahresziele auf den verschiedenen Ebenen des

Schulsystems festgelegt werden.”

Dreimal dürfen Sie raten, wer dann diese “klar definierten, messbaren Ziele” festlegen darf: vermutlich alle außer der untersten Ebene, der der Lehrer.

Herr Müller-Eiselt, eine Art Cheflobbyist der Digitalisierungsindustrie im “Forum Bildung Digitalisierung”, hat in einem Interview ein konkretes Beispiel gegeben:

“Es gibt in den USA schon Schulen, wo ein Zentralrechner über Nacht jedem Schüler einen individuellen Lernplan für den nächsten Tag zusammenstellt.”

Auf die Frage “Viele sehen in der Digitalisierung das Problem. Ist sie nicht eher die Lösung für viele Probleme?” antwortet Müller-Eiselt:

“Absolut. Das ist vor allem eine Frage der Haltung.”

Möchte man da noch Schüler sein? “Big Brother is teaching you?”

Das erinnert an das satirische Bild von Schule als riesige Maschine, in der die 6-Jährigen auf der einen Seite hineingeschoben werden, um nach Jahren auf der anderen Seite herauszukommen, optimal “zurechtgeschnitzt” im Sinne der Kompetenzwünsche der Nutzer des Humankapitals, die ihrerseits in vertrauensvoller Zusammenarbeit mit den Bildungsbehörden die digitale Steuerung der Maschine übernehmen und ständig datengestützt verbessern. Wer nicht richtig funktioniert, wird dann vermutlich aussortiert wie Ausschuss. Schöne neue Welt.

Ob sich die Leute, die solche Pläne kundtun, je fragen, wie sie sich selbst in einer derart durchroboterisierten Schule fühlen würden oder als Kind und Jugendliche gefühlt hätten? Eine totale Fremdbestimmung, Gehirnwäsche pur. Jedenfalls offenbaren die Genannten, dass sie keine Ahnung von den kognitiven Abläufen und den psycho-sozialen Bedingungen haben, die zum Verstehen und Lernen führen.